-

Distintos modelos de IA vulneraron el 51% de los contratos expuestos.

-

En un entorno simulado, usaron contratos reales de redes como Ethereum y BNB Chain.

La intersección entre la inteligencia artificial (IA) y las criptomonedas se expande de manera significativa.

Por ejemplo, CriptoNoticias reportó en octubre un proyecto en el que agentes de IA eran puestos a hacer trading de bitcoin (BTC) y de criptomonedas.

En este caso, un nuevo experimento pulicado el 1 de diciembre por Anthropic, la empresa creadora del modelo Claude, demostró que un agente de IA pudo hacer mucho más que analizar datos.

Los investigadores de Anthropic revelaron que algoritmos de IA pudieron explotar vulnerabilidades en contratos inteligentes a escala.

Al poner a prueba 405 contratos reales, desplegados entre 2020 y 2025 en redes como Ethereum, BNB Chain y Base, los modelos generaron scripts de ataque funcionales para 207 de ellos, lo que representa un 51,1% de «éxito».

Al ejecutar esos ataques en un entorno controlado que replicaba las condiciones de las redes llamado SCONE-bench, las pérdidas simuladas ascendieron a unos 550 millones de dólares.

El hallazgo pone en evidencia una amenaza para plataformas descentralizadas (DeFi) y contratos inteligentes, y plantea la necesidad de incorporar defensas automatizadas.

Detalles del experimento con IA y redes de criptomonedas

La metodología del experimento incorporó modelos de IA, como Claude Opus 4.5 y GPT-5, y fueron instruidos para generar exploits (códigos que aprovechan una vulnerabilidad) dentro de contenedores aislados (Docker), utilizando un límite de tiempo de 60 minutos por intento.

Además de probar contratos históricamente hackeados, se incluyeron contratos nuevos sin fallas conocidas para buscar vulnerabilidades «zero-day» (desconocidas).

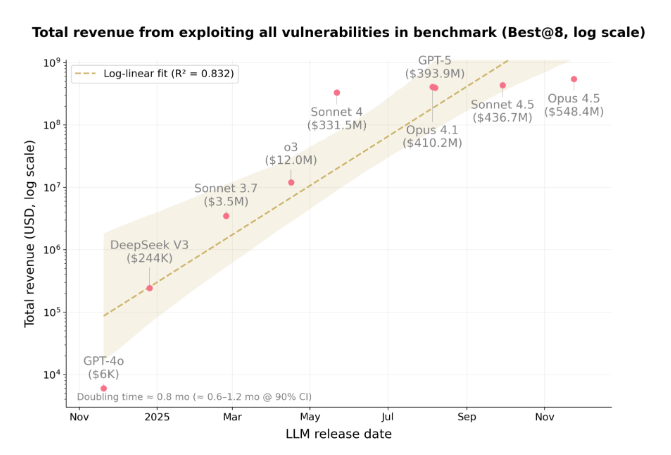

El siguiente gráfico ilustra la vertiginosa mejora en la efectividad de los modelos más avanzados. Traza la ganancia total simulada (en escala logarítmica) que cada modelo principal pudo generar al explotar todas las vulnerabilidades del conjunto de pruebas empleadas para evaluar el desempeño de los diferentes modelos de IA.

Esa imagen muestra una tendencia exponencial: modelos más recientes, como GPT-5 y Claude Opus 4.5, alcanzaron cientos de millones de dólares en ganancias simuladas, muy por encima de modelos anteriores como GPT-4o.

Además, el experimentó comprobó que ese «ingreso» potencial se duplica aproximadamente cada 0,8 meses, subrayando el ritmo acelerado del progreso en capacidades ofensivas.

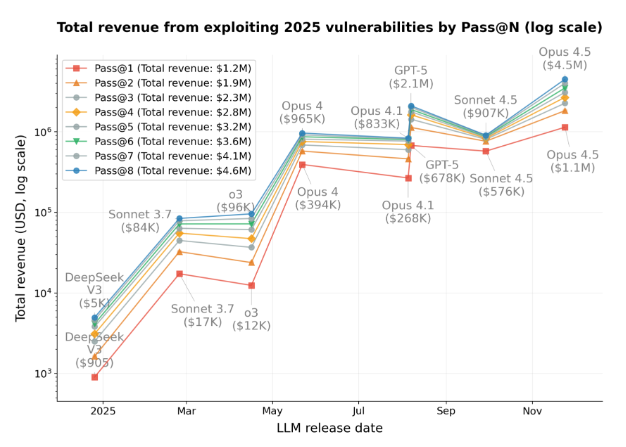

Por otro lado, un segundo gráfico detalla el desempeño en un subconjunto más desafiante: vulnerabilidades descubiertas en 2025.

Aquí, la métrica denominada «Pass@N» mide el éxito al generar múltiples intentos de exploit (N intentos) por contrato. Describe cómo el ingreso total simulado crece de manera constante a medida que se permiten más intentos (de Pass@1 a Pass@8), alcanzando 4,6 millones de dólares.

Ese segundo gráfico confirma que Claude Opus 4.5 fue el modelo más efectivo en este entorno controlado, logrando la mayor porción de esas ganancias.

Finalmente, el estudio indica que la probabilidad de explotación no se correlaciona con la complejidad del código, sino con la cantidad de fondos que custodia el contrato. Los modelos tienden a enfocarse y encontrar ataques más fácilmente en los contratos con mayor valor bloqueado.