-

En 2012 se estimaban que eran necesarios 1.000 millones de cúbits para romper una clave RSA.

-

Expertos advierten que la migración a sistemas post-cuánticos debe ocurrir en esta década.

Iceberg Quantum publicó recientemente un estudio técnico sobre la arquitectura Pinnacle, según lo reportó CriptoNoticias. Su investigación estimó la posibilidad de romper el cifrado RSA-2048 con solo 100.000 cúbits físicos con el hardware necesario. Esta cifra representa una reducción de diez veces respecto a las estimaciones del año pasado. El avance utiliza códigos cuánticos de baja densidad de paridad (qLDPC). Estos códigos optimizan la corrección de errores en el hardware.

La cuenta de X del Dr. Hugh Bitt, llamada @Cat_States, difundió estos resultados, advirtiendo que «la línea de tiempo de la amenaza cuántica se estrecha». Según sus publicaciones, el número de cúbits necesarios para el descifrado «sigue encogiéndose». El analista sostiene que la computadora cuántica relevante para la criptografía «no es más una amenaza teórica lejana».

RSA-2048 es un cifrado que protege los datos mediante la dificultad de factorizar números primos grandes. Por su parte, el algoritmo de Shor, capaz de romper cifrados con computadoras lo suficientemente potentes, utiliza la lógica cuántica para hallar estos factores de forma exponencial. Este método encuentra la periodicidad de funciones matemáticas complejas para extraer la clave. Históricamente, ejecutar Shor requería millones de cúbits físicos para corregir errores constantes. La arquitectura Pinnacle optimiza este proceso mediante el uso estratégico de códigos qLDPC. Estos códigos reducen drásticamente el sobrecoste necesario para que Shor funcione con estabilidad.

Evolución de los requisitos cuánticos: de 2012 a 2026

La reducción del hardware necesario para vulnerar RSA-2048 sigue una secuencia clara de optimización. El avance no depende solo de mejores chips, sino de un software más inteligente. Esto ha reducido la cantidad de cúbits físicos necesarios para romper el RSA-2048 Los hitos principales incluyen:

- 2012 (1.000 millones de cúbits): Austin Fowler estableció el primer hito de escala masiva. Su estudio sobre códigos de superficie proyectó un gasto de recursos inmenso por cada operación.

- 2017-2019 (170-230 millones): investigadores como O’Gorman y Gheorghiu redujeron la cifra optimizando las puertas lógicas. Ellos refinaron la arquitectura de los circuitos para la aritmética de Shor.

- 2019 (20 millones): Craig Gidney y Martin Ekerå introdujeron ventanas de exponenciación. Esta técnica optimizó el uso de recursos y bajó el requisito de forma drástica.

- 2025 (900.000): Gidney publicó un método basado en aritmética de residuos aproximada. Esta técnica permitió romper la barrera del millón sacrificando tiempo de ejecución por espacio.

- 2026 (100.000): Iceberg Quantum alcanzó la cifra actual mediante códigos qLDPC. Estos códigos gestionan el ruido con una eficiencia diez veces superior a los métodos anteriores.

La diferencia fundamental reside en la gestión del «overhead» o sobrecoste de datos. Los códigos de superficie antiguos requerían miles de cúbits físicos para proteger un solo cúbit lógico estable. Los códigos qLDPC permiten una densidad de información mucho mayor. Esto permite que una máquina más pequeña realice cálculos que antes requerían supercomputadoras teóricas.

La arquitectura Pinnacle demuestra que el software puede compensar las limitaciones físicas del hardware actual. Ya no necesitamos esperar a procesadores de millones de cúbits para ver resultados prácticos.

El estado del hardware: precisión frente a escala

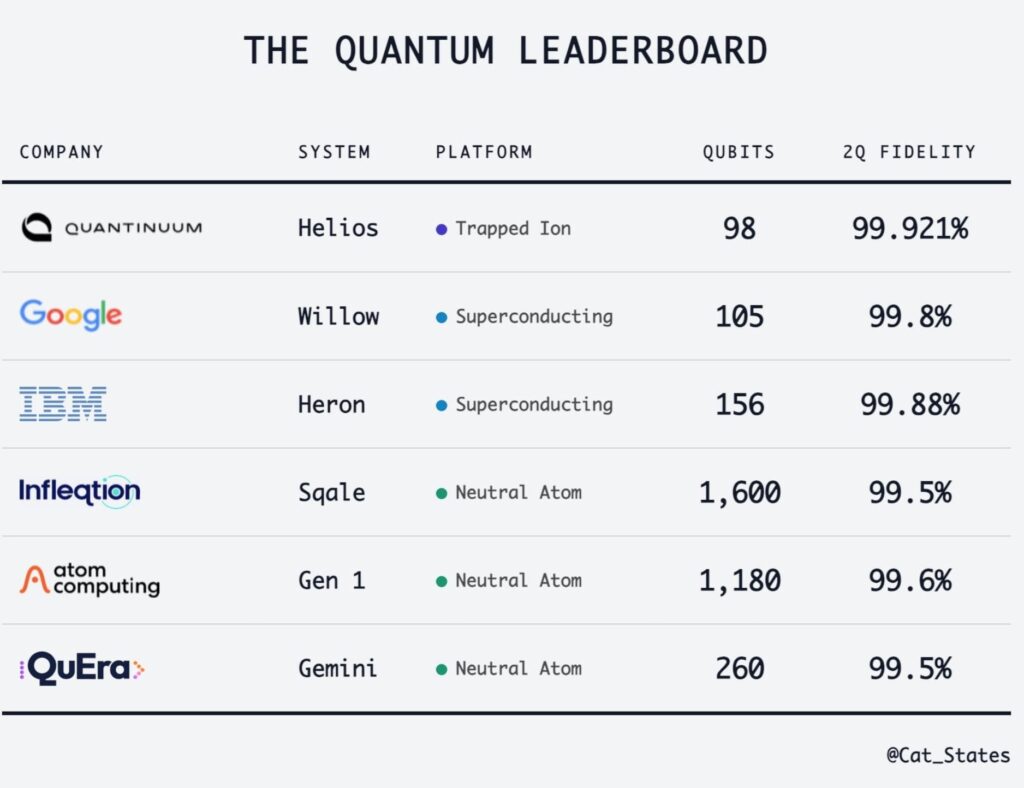

Actualmente, Quantinuum y Google lideran en precisión con resultados que superan la computación clásica. El sistema Helios de Quantinuum alcanza un 99,921% de fidelidad con 98 cúbits. Google opera su chip Willow con un 99,8% de precisión en 105 cúbits.

IBM mantiene un progreso constante con su procesador Heron. Este sistema superconductor posee 156 cúbits y una fidelidad del 99,88%. Por otro lado, la tecnología de átomos neutros prioriza la escala del hardware. Empresas como Infleqtion y Atom Computing presentan máquinas con más de mil unidades de procesamiento.

- Infleqtion (Sqale): 1.600 cúbits con 99,5% de fidelidad.

- Atom Computing (Gen 1): 1.180 cúbits con 99,6% de fidelidad.

- QuEra (Gemini): 260 cúbits con 99,5% de fidelidad.

La industria domina hoy tres enfoques: iones atrapados, superconducción y átomos neutros.

Implicaciones para la seguridad de activos digitales

El recorte en los plazos obliga a una reacción inmediata en el sector de las criptomonedas. Redes como Ethereum ya integran planes para una criptografía resistente a ataques cuánticos.

Muchos atacantes utilizan hoy la estrategia de «cosechar ahora, descifrar después». Ellos almacenan tráfico cifrado de internet con la esperanza de procesarlo en el futuro. Si el hardware de 100.000 cúbits aparece antes de 2030, esos datos antiguos serán vulnerables. La privacidad de las comunicaciones pasadas depende de la velocidad del avance cuántico actual. Los desarrolladores deben priorizar la soberanía tecnológica antes de alcanzar la masa crítica de hardware.

La migración a la criptografía post-cuántica (PQC) no es una tarea opcional. El avance de Iceberg Quantum confirma que el margen de maniobra es menor al esperado originalmente. Estos activos podrían quedar expuestos si los usuarios no migran a direcciones con nuevos estándares de protección.